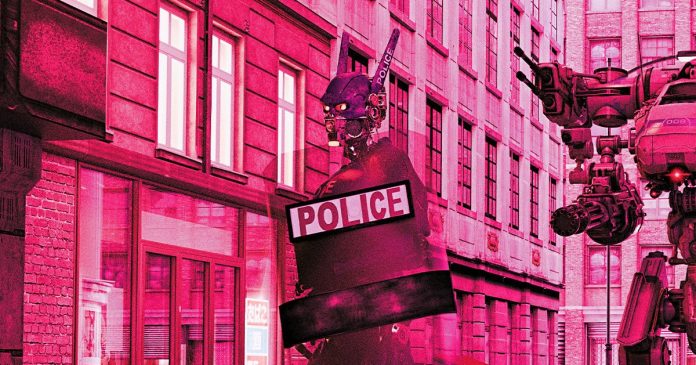

Εγκλήματα Bot

Ένα αστυνομικό τμήμα στο Ηνωμένο Βασίλειο δοκιμάζει ένα σύστημα με τεχνητή νοημοσύνη που θα μπορούσε δυνητικά να βοηθήσει στην επίλυση ανεξιχνίαστων υποθέσεων, συμπυκνώνοντας δεκαετίες ντετέκτιβικής εργασίας σε λίγες ώρες, αναφέρει το Sky News.

Ωστόσο, προς το παρόν δεν υπάρχουν διαθέσιμες πληροφορίες σχετικά με το ποσοστό ακρίβειας αυτής της πλατφόρμας που αναπτύχθηκε στην Αυστραλία και ονομάζεται Soze, γεγονός που εγείρει σοβαρές ανησυχίες επειδή τα μοντέλα τεχνητής νοημοσύνης συχνά παράγουν εξαιρετικά ανακριβή αποτελέσματα ή ψευδείς εντυπώσεις πληροφοριών.

Το Soze χρησιμοποιείται από το Αστυνομικό Τμήμα Avon and Somerset, το οποίο εξυπηρετεί περιοχές της Νοτιοδυτικής Αγγλίας, για τη σάρωση και εξέταση εγγράφων, όπως οικονομικές καταστάσεις, βίντεο, λογαριασμούς μέσων κοινωνικής δικτύωσης, μηνύματα ηλεκτρονικού ταχυδρομείου και άλλα είδη υλικού, προκειμένου να δοκιμαστεί το πρόγραμμα.

Το Sky αναφέρει ότι η τεχνητή νοημοσύνη ήταν σε θέση να σαρώσει στοιχεία από 27 ‘πολύπλοκες’ υποθέσεις σε περίπου 30 ώρες – κάτι που ισοδυναμεί με 81 χρόνια ανθρώπινης εργασίας, κάτι που είναι εντυπωσιακό.Δεν είναι περίεργο που αυτό το αστυνομικό τμήμα ενδιαφέρεται να χρησιμοποιήσει αυτό το πρόγραμμα, επειδή αυτοί οι αριθμοί ακούγονται σαν πολλαπλασιαστής δυνάμεων σε στεροειδή – γεγονός που το καθιστά ιδιαίτερα δελεαστικό για τις αρχές επιβολής του νόμου που μπορεί να είναι στενές όσον αφορά το προσωπικό και τους δημοσιονομικούς περιορισμούς.

‘Μπορεί να έχετε μια επανεξέταση μιας ανεξιχνίαστης υπόθεσης που φαίνεται αδύνατη λόγω του όγκου του υλικού και να την τροφοδοτήσετε σε ένα σύστημα όπως αυτό, το οποίο μπορεί να την απορροφήσει και στη συνέχεια να σας δώσει μια αξιολόγηση’, δήλωσε στο Sky ο πρόεδρος του Εθνικού Συμβουλίου Αρχηγών Αστυνομίας του Ηνωμένου Βασιλείου, Gavin Stephens.’Μπορώ να το δω αυτό να είναι πραγματικά, πραγματικά χρήσιμο.’.

Minority Report

Η δημιουργία μιας βάσης δεδομένων για μαχαίρια και σπαθιά -τα οποία πολλοί ύποπτοι έχουν χρησιμοποιήσει για να επιτεθούν και να ακρωτηριάσουν ή να σκοτώσουν θύματα στο Ηνωμένο Βασίλειο- είναι ένα άλλο έργο τεχνητής νοημοσύνης που ανέφερε ο Stephens.

Ο Stephens φαίνεται αισιόδοξος για την επικείμενη απελευθέρωση αυτών των εργαλείων ΤΝ, αλλά θα ήταν συνετό να επιβεβαιωθεί πρώτα ότι λειτουργούν όπως προβλέπεται, καθώς η ΤΝ είναι γνωστό ότι είναι επιρρεπής σε σφάλματα και ψευδώς θετικά αποτελέσματα, ιδίως στο πλαίσιο της επιβολής του νόμου.

Η αναγνώριση προσώπου με AI μπορεί επίσης να οδηγήσει σε ψευδείς συλλήψεις, με μειονότητες να κατηγορούνται ψευδώς για εγκλήματα που δεν διέπραξαν.Ένα μοντέλο που χρησιμοποιήθηκε για να προβλέψει την πιθανότητα ενός υπόπτου να διαπράξει άλλο έγκλημα στο μέλλον ήταν λανθασμένο και προκατειλημμένο έναντι των μαύρων – ακούγεται σαν κάτι βγαλμένο από το βιβλίο του Philip K.Dick ‘Minority Report’, που αργότερα μεταφέρθηκε στην ταινία του Στίβεν Σπίλμπεργκ το 2002.

Η Επιτροπή Πολιτικών Δικαιωμάτων των ΗΠΑ επέκρινε πρόσφατα τη χρήση της τεχνητής νοημοσύνης στην αστυνόμευση λόγω αυτών των ανησυχητικών ανακριβειών.

Υπάρχει η εσφαλμένη αντίληψη ότι επειδή πρόκειται για μηχανές που εκτελούν αναλύσεις, θα είναι τέλειες και ακριβείς.Ωστόσο, δεδομένου ότι βασίζονται σε δεδομένα που συλλέγονται από τον άνθρωπο, τα οποία υπόκεινται σε προκατάληψη και ευθεία σφάλματα, εισάγονται από την αρχή κοινά προβλήματα.

Περισσότερα για την τεχνητή νοημοσύνη και την εργασία της αστυνομίας: Οι αστυνομικοί λένε ότι οι τεχνητές νοημοσύνες με παραισθήσεις είναι έτοιμες να γράψουν αστυνομικές εκθέσεις που θα μπορούσαν να στείλουν ανθρώπους στη φυλακή.

Bot Crimes

Ένα αστυνομικό τμήμα στο Ηνωμένο Βασίλειο δοκιμάζει ένα σύστημα με τεχνητή νοημοσύνη που θα μπορούσε ενδεχομένως να βοηθήσει στην επίλυση ανεξιχνίαστων υποθέσεων, συμπυκνώνοντας δεκαετίες αστυνομικής εργασίας σε λίγες μόνο ώρες, αναφέρει το Sky News.

Ωστόσο, επί του παρόντος δεν υπάρχουν διαθέσιμες πληροφορίες σχετικά με το ποσοστό ακρίβειας αυτής της πλατφόρμας που αναπτύχθηκε στην Αυστραλία και ονομάζεται Soze, γεγονός που εγείρει σοβαρές ανησυχίες, επειδή τα μοντέλα τεχνητής νοημοσύνης συχνά παράγουν εξαιρετικά ανακριβή αποτελέσματα ή ψευδείς εντυπώσεις πληροφοριών.

Το Soze χρησιμοποιείται από το Αστυνομικό Τμήμα Avon and Somerset, το οποίο εξυπηρετεί περιοχές της νοτιοδυτικής Αγγλίας, για τη σάρωση και εξέταση εγγράφων όπως οικονομικές καταστάσεις, βίντεο, λογαριασμούς μέσων κοινωνικής δικτύωσης, μηνύματα ηλεκτρονικού ταχυδρομείου και άλλα είδη υλικού, προκειμένου να δοκιμαστεί το πρόγραμμα.

Το Sky αναφέρει ότι η τεχνητή νοημοσύνη μπόρεσε να σαρώσει στοιχεία από 27 ‘πολύπλοκες’ υποθέσεις σε περίπου 30 ώρες – κάτι που ισοδυναμεί με 81 χρόνια ανθρώπινης εργασίας, πράγμα που είναι εντυπωσιακό.Δεν είναι περίεργο που αυτό το αστυνομικό τμήμα ενδιαφέρεται να χρησιμοποιήσει αυτό το πρόγραμμα, επειδή αυτοί οι αριθμοί ακούγονται σαν πολλαπλασιαστής δυνάμεων σε στεροειδή – γεγονός που το καθιστά ιδιαίτερα δελεαστικό για τις αρχές επιβολής του νόμου που μπορεί να είναι περιορισμένες από άποψη προσωπικού και προϋπολογισμού.

‘Μπορεί να έχετε μια επανεξέταση μιας ανεξιχνίαστης υπόθεσης που απλώς φαίνεται αδύνατη λόγω του όγκου του υλικού που υπάρχει και να την τροφοδοτήσετε σε ένα σύστημα όπως αυτό, το οποίο μπορεί απλώς να την απορροφήσει και στη συνέχεια να σας δώσει μια αξιολόγηση’, δήλωσε στο Sky ο πρόεδρος του Εθνικού Συμβουλίου Αρχηγών Αστυνομίας του Ηνωμένου Βασιλείου Gavin Stephens.’Μπορώ να το δω αυτό να είναι πραγματικά, πραγματικά χρήσιμο.’.

Minority Report

Η δημιουργία μιας βάσης δεδομένων για μαχαίρια και σπαθιά – τα οποία πολλοί ύποπτοι έχουν χρησιμοποιήσει για να επιτεθούν και να ακρωτηριάσουν ή να σκοτώσουν θύματα στο Ηνωμένο Βασίλειο – είναι ένα άλλο έργο τεχνητής νοημοσύνης που ανέφερε ο Stephens.

Ο Stephens φαίνεται αισιόδοξος για την επικείμενη κυκλοφορία αυτών των εργαλείων τεχνητής νοημοσύνης, αλλά θα ήταν συνετό να επιβεβαιωθεί πρώτα ότι λειτουργούν όπως προβλέπεται, καθώς η τεχνητή νοημοσύνη είναι γνωστό ότι είναι επιρρεπής σε σφάλματα και ψευδώς θετικά αποτελέσματα, ιδίως στο πλαίσιο της επιβολής του νόμου.

Η αναγνώριση προσώπου με AI μπορεί επίσης να οδηγήσει σε ψευδείς συλλήψεις, με μειονότητες να κατηγορούνται ψευδώς για εγκλήματα που δεν διέπραξαν.Ένα μοντέλο που χρησιμοποιήθηκε για να προβλέψει την πιθανότητα ενός υπόπτου να διαπράξει άλλο έγκλημα στο μέλλον ήταν λανθασμένο και προκατειλημμένο έναντι των μαύρων – ακούγεται σαν κάτι βγαλμένο από το βιβλίο του Philip K.Dick ‘Minority Report’, που αργότερα μεταφέρθηκε στην ταινία του Στίβεν Σπίλμπεργκ το 2002.

Η Επιτροπή Πολιτικών Δικαιωμάτων των ΗΠΑ επέκρινε πρόσφατα τη χρήση της τεχνητής νοημοσύνης στην αστυνόμευση λόγω αυτών των ανησυχητικών ανακριβειών.

Υπάρχει η εσφαλμένη αντίληψη ότι επειδή πρόκειται για μηχανές που εκτελούν αναλύσεις, θα είναι τέλειες και ακριβείς.Ωστόσο, δεδομένου ότι βασίζονται σε δεδομένα που συλλέγονται από τον άνθρωπο, τα οποία υπόκεινται σε προκατάληψη και ευθεία σφάλματα, εισάγονται από την αρχή κοινά προβλήματα.

Περισσότερα για την τεχνητή νοημοσύνη και την εργασία της αστυνομίας: Οι αστυνομικοί λένε ότι οι τεχνητές νοημοσύνες με παραισθήσεις είναι έτοιμες να γράψουν αστυνομικές εκθέσεις που θα μπορούσαν να στείλουν ανθρώπους στη φυλακή.